人工智能还是人工智障:西班牙女研究员找工作,居然被AI歧视了?

不得不承认的一个事实是,如今我们生活的方方面面都被人工智能所影响着。Artificial Intelligence旨在研究使计算机来模拟人的某些思维过程和智能行为,它研究的范围很广:从模拟人类行为甚至感情的机器人,到自动识别用户特征并推送相关消息的智能系统,都需要依托AI来完成。

人工智能确实给我们的生活带来了很多便利,但同时,在试图模仿人类行为(和思维)的道路上,AI们也闹出了很多笑话,所以被称为“人工智障”也不是没原因的:比如在智能机器人界,前有全自动婴儿拍奶器,

后有自动口红机……

不用说,同样“智障”的还有人工智能识别系统:

(图源:Twitter@Kanayuki_Chan)

如果上述的智障表现只是让人觉得好笑的话,那么接下来的这个状况可能就会让人细思恐极了——人工智能居然还会性别歧视。

现在我们都会通过各种app找工作,可是你有没有想过,当你在个人信息性别一项选中了女性的那一刻起,就意味着你将错失掉一大堆优质的招聘信息?

西班牙一女子就有过这样的经历。

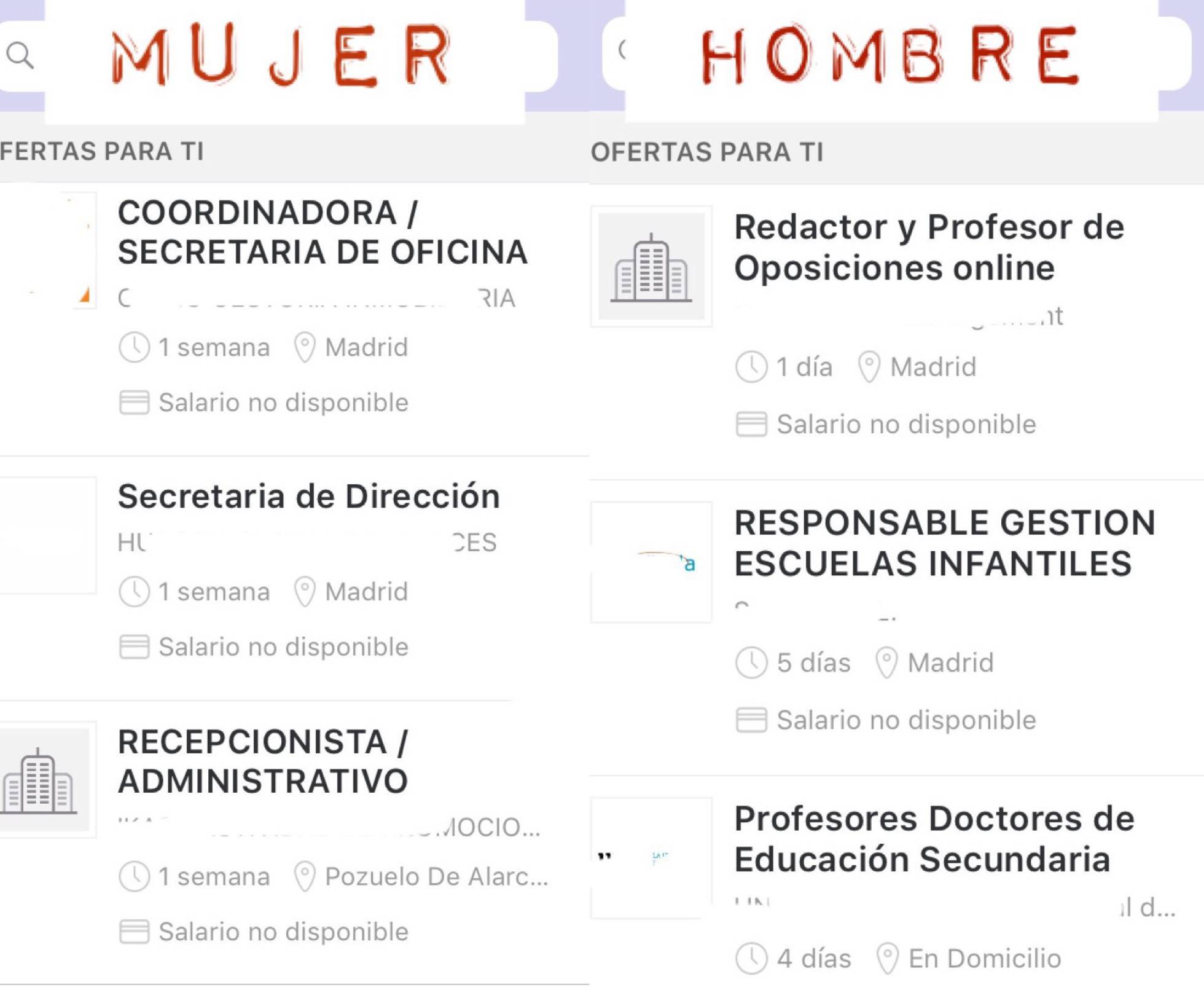

一名不愿意透露姓名的女士(化名为E. G. ) 是一名医生和研究员。她结束学业后,在某一招聘软件上注册登录了信息,然而结果却令她很不满意。仅仅因为在个人资料中的性别选项里勾选了女性,系统就频繁地给她推送所谓 “适合” 女性的岗位——例如秘书,行政管理人员等。于是她试着将用户资料中的女性改为男性,几天后,她开始陆续地收到了高质量且高薪的工作推送。

给女性推送秘书和前台接待员工作;男性则为管理负责人和医生等

(图源:)

该女士把她这一用户体验分享给了《国家报》(El País)。通过报社的联系和沟通,该女士得到了招聘平台给的答复:

在这条新闻的下面,很多人在评论区里发表了自己对这件事的看法:

有网友表示:“人工智能会通过谷歌和其他人们所创建的数据库来学习,因此人工智能会产生偏见。”

(图源:)

还有人把这一现象归因于女性特殊的身体生理需求:“你雇用了一名女性,但她突然会因为要休产假或因为各种其他原因而请假休息。”

(图源:)

也有人说:“这是意愿问题,是社会影响的问题,也是许多公司在面临怀孕而造成的风险时所设下的障碍问题。”

(图源:)

对此,也有网友回复说:“是的。但是一码归一码。我们不应该也不能改变生物特征。但是接受因怀孕而导致的歧视,对于我们这个本来就少子化的社会是不可取的。”

(图源:)

无独有偶,弗吉尼亚大学(la Universidad de Virginia)的一个团队同样发表了一项研究,在该研究中指出:人工智能不仅不能避免由于人类偏见而产生的错误,反而会加剧歧视现象,并且在平时工作生活的各个方面强化许多刻板印象。比如,该团队发现AI会自动将厨房里的人识别为女性。

(图源:图虫)

(图源:)

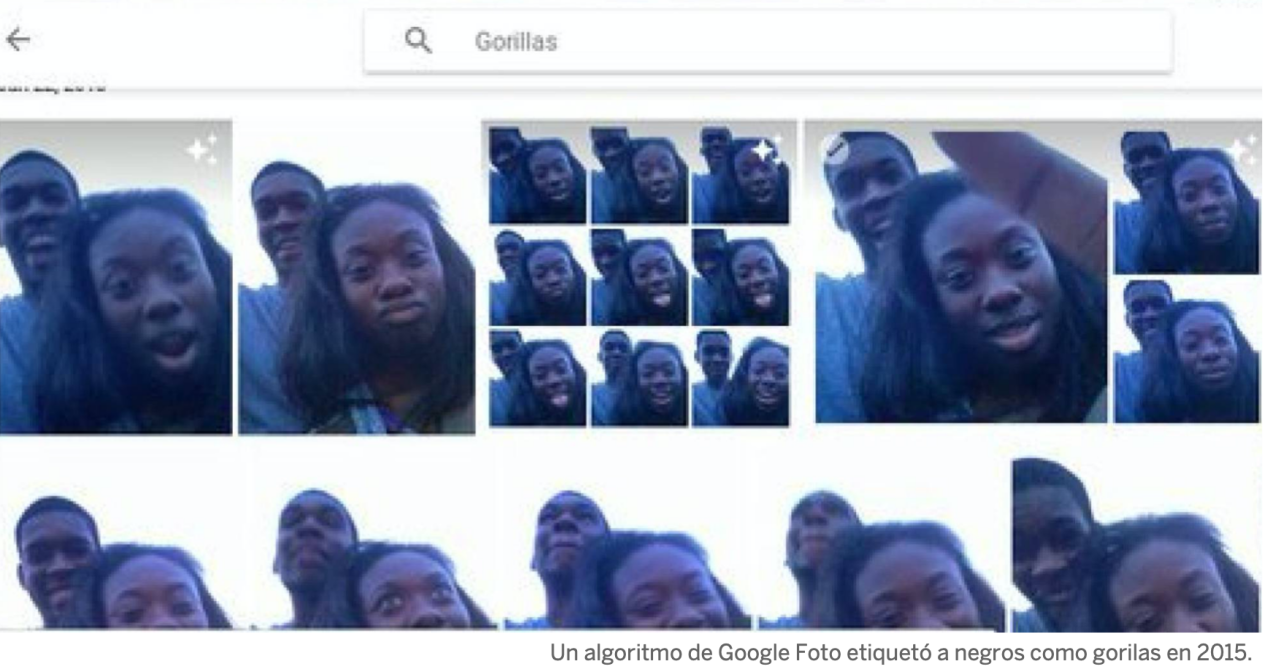

除了性别歧视,我们 “万能” 的AI还会种族歧视呢。2015年6月,一名谷歌图库的用户发现系统把他的黑人朋友标记为了大猩猩。

搜索“Gorillas”会出现朋友的照片

(图源:)

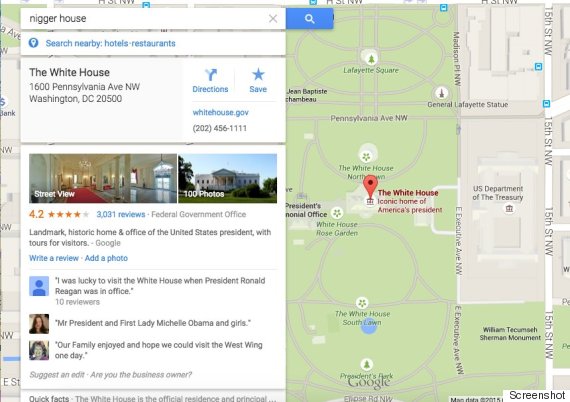

更过分的是,曾经有一段时间,在谷歌地图搜索“nigger house”(nigger是对于黑人的侮辱性称呼),会出现奥巴马居住的白宫(当时正处于奥巴马任期)。

(图源:)

看来,人工智能在模仿人类行为和思维的同时,也将人类社会的偏见带到了计算机领域,可以说是学会了不少的 “坏毛病”。我们没办法责备这些算法,因为从某种层面讲,它确实“非常准确”地复刻了人类的想法。

ref:

https:///tecnologia/2019/02/18/actualidad/1550487916_452253.html

https:///elpais/2017/09/19/ciencia/1505818015_847097.html

声明:双语文章中,中文翻译仅代表译者个人观点,仅供参考。如有不妥之处,欢迎指正。未经允许,请勿转载